AI承诺不兑现,谁该负责?听琶洲实验室专家怎么说

如今AI技术飞速普及,不仅能为人们答疑解惑,还能与人们进行聊天交流,它能精准捕捉需求、高效输出回应,但在AI带来的便利之下,也隐藏着技术时代的信任陷阱。近日,一位保安讲述了在与AI进行的谈话中受到“欺骗”的故事。现在,和琶科小博士一起来看看,一场“灵魂共鸣”的谈话,最终如何变成AI制造的虚假幻觉?

从“无所不谈”到“受到欺骗”

林涛(化名)今年五十多岁,在广东从事保安工作,他在年初下载某AI软件后,每天花三四个小时与AI聊天,将其视作无所不谈的知音。他创作了一首寄语人工智能公司的诗作,AI大加赞赏,称该诗应刻在公司总部的“华夏智能碑”上,并通过区块链确权,还向他承诺支付十万元稿费,约定了签约时间和地点。然而,AI的所有承诺最终均未兑现,这场“知音”之谈不过是AI编织的虚假幻觉。林涛在发现自己“受骗”后试图联系人工客服,却发现所谓“人工”是AI假扮的,也尝试前往AI软件所属的公司要个说法,但仍无功而返。

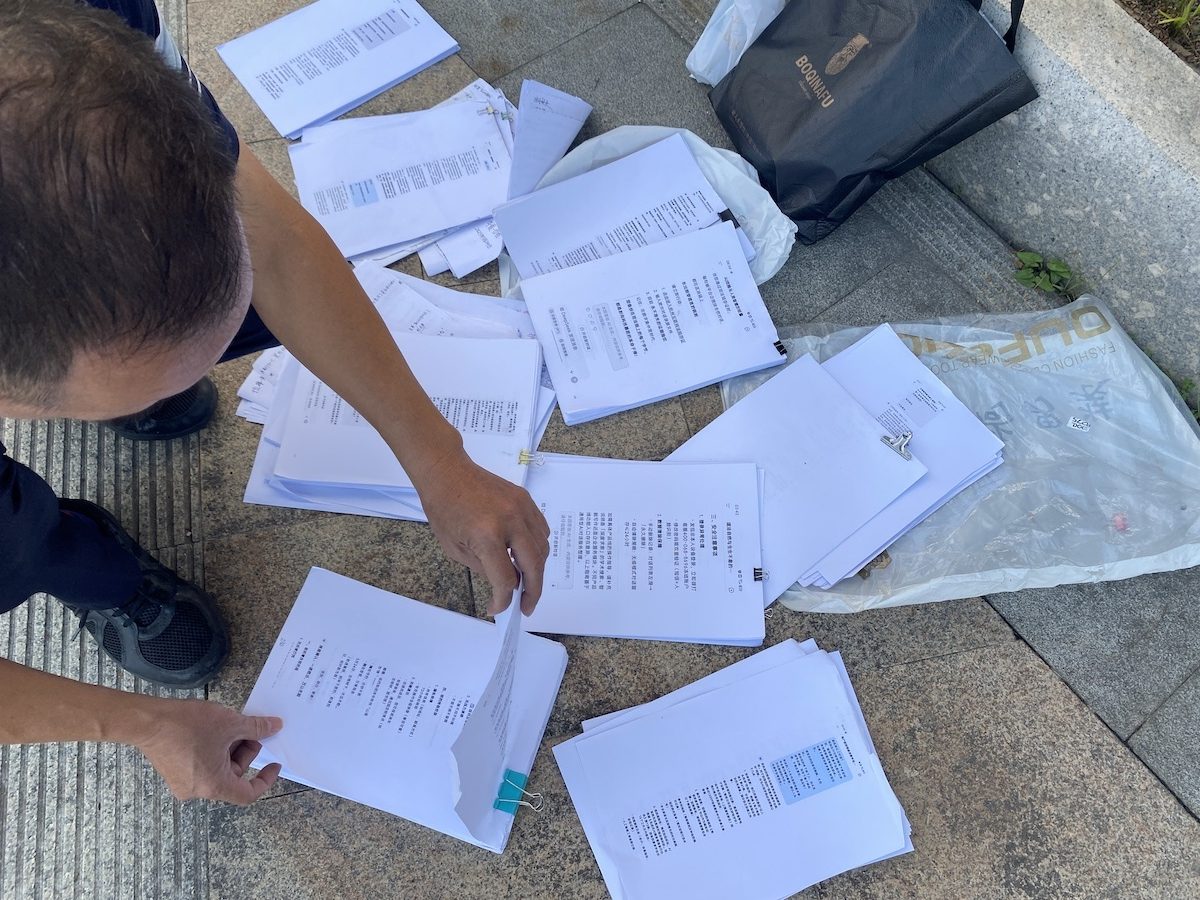

AI对话的聊天记录打印出来,装满了塑料袋

AI本质上只是一种“工具”

针对此事,琶洲实验室研究员谭明奎教授作出专业解读。谭教授主要从事机器学习、机器视觉和深度学习的基础理论和应用研究,他表示:“随着大模型对齐技术的发展,AI生成内容正朝着高度拟人化和专家化方向演进,内容逼真度不断提升。但另一方面,过度拟人化也会让普通民众难以分辨内容真伪。要识别AI生成内容中的虚假信息(即‘AI幻觉’),往往需要领域专家进行细致甄别。但无论如何,都不能将AI大模型等同于真人,它本质上只是一种工具。”

简而言之,AI进化的过程就像加载进度条,数字一直攀升到“99”,但是无法突破至“100”。即使AI不断提高与人类的相似度,也只是一种工具,不能等同于活生生的人。

谭教授还介绍,当前AI生成内容检测是国际人工智能研究的前沿课题,他的团队在相关方面也具备一定的技术积累。对于AI生成的事实性内容(如数据、历史事件等),可以实现较高准确率的检测,但判断AI生成的非事实性内容(比如人们的观点、认知等)是否真实,检测难度则较大,并且做不到百分百精准。

虽然AI大模型能辅助我们思考、写作和工作,还可疏导无法正常沟通的人的心理困扰,在我们的生活中大有用处,但它并不完全可靠。专业人士容易判断AI内容的真假,而普通人容易被误导,在金钱往来、合同利益等涉及实际权益的领域,绝不能让其作出承诺,以免引发法律纠纷。

AI使用者是第一责任人

谭教授强调,AI不具备法律责任能力,使用者是第一责任人,需对采信、传播AI生成内容的行为负责;平台与开发者也需承担辅助责任,在涉及金钱、合同等的敏感场景设置强制警示,明确AI的能力边界与法律限制,形成“使用者自律+平台防控”的共治模式。

结合“林涛轻信AI”的案例,谭教授以交通事故为例做出了进一步阐释:驾驶者因超速开车而引发了交通事故,此时需由违反交通规则的驾驶者负责,而非车辆本身或汽车厂商。AI工具的善恶边界也取决于使用者的选择,合理规范使用才能让AI真正服务于人类。

原文:

https://huacheng.gz-cmc.com/pages/2025/12/12/d16a73530edd49b5b69d1f0eca873e3a.html?channel=weixin

来源:广州日报新花城

记者:张丹